下面我将为你详细解析Facebook的网站架构。

(图片来源网络,侵删)

核心架构原则:规模化、高可用、高性能

在深入细节之前,首先要理解Facebook架构设计的几个核心原则,这些原则驱动了所有技术决策:

- 可扩展性:系统必须能够支持数十亿用户、每天数万亿次的请求和数据存储,这意味着架构必须是水平扩展的,而不是垂直扩展(即不断增加单台服务器的性能)。

- 高可用性:服务必须7x24小时不间断运行,任何单一组件的故障都不能导致整个系统或核心服务(如新闻流、消息)瘫痪。

- 高性能:用户对延迟极其敏感,页面加载时间每增加100毫秒,活跃用户数都会显著下降,架构必须优化全球范围内的数据访问速度。

- 数据一致性:对于社交网络,数据一致性至关重要,你看到的好友列表、点赞数、评论等必须是准确且最新的。

- 成本效益:作为一家大型科技公司,成本控制是关键,Facebook通过构建自己的硬件和软件基础设施来降低成本。

架构演进:从单体到分布式

Facebook的架构大致经历了三个主要阶段:

早期阶段:PHP + LAMP (单体应用)

- 技术栈:Linux, Apache, MySQL, PHP。

- 特点:所有功能(用户资料、新闻流、照片等)都写在一个巨大的PHP代码库中,所有请求都由少数几台Web服务器处理,数据存储在少数几台大型MySQL数据库中。

- 问题:随着用户量爆炸式增长,这种单体架构很快遇到了瓶颈:

- 代码库臃肿:代码难以维护和部署。

- 数据库压力巨大:单台数据库无法承受读写压力。

- 扩展性差:无法对特定功能进行独立扩展。

中期阶段:服务化拆分

为了解决单体架构的问题,Facebook开始将庞大的应用拆分成多个独立的服务。

- 拆分方式:按照业务功能进行拆分,

- 用户服务

- 好友关系服务

- 新闻流服务

- 照片服务

- 消息服务

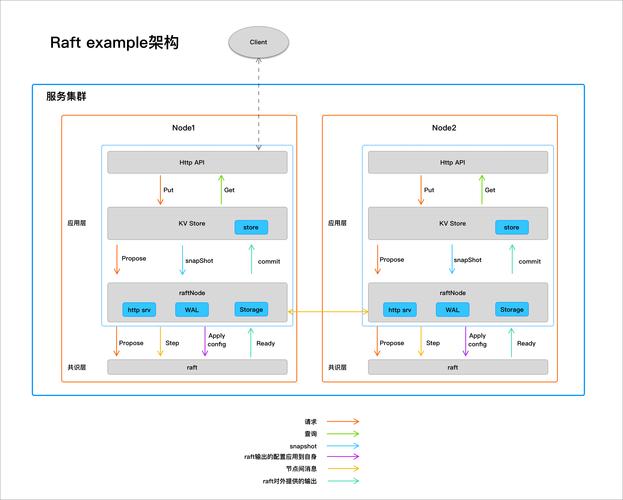

- 通信方式:这些服务之间通过内部的RPC(远程过程调用)框架(如Thrift)进行通信。

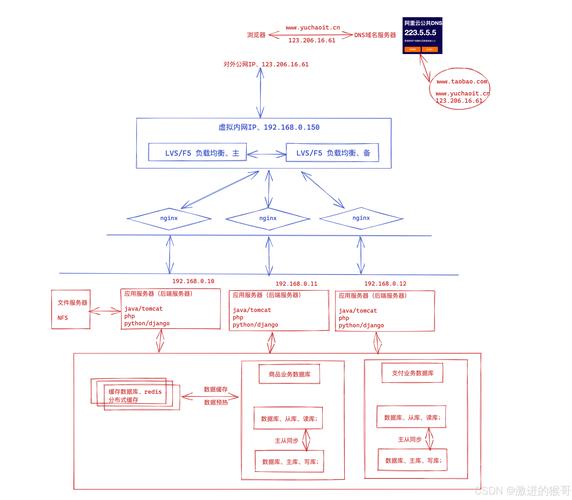

- 数据库:开始从单一MySQL数据库向主从复制和分库分表演进,以分散读写压力。

现代阶段:全球分布式微服务架构

这是Facebook当前采用的架构,其核心思想是“数据本地化”和“计算靠近数据”。

(图片来源网络,侵删)

- 核心思想:为了在全球范围内提供低延迟体验,Facebook将数据中心部署在世界各地,用户的个人数据(好友、照片、个人资料)存储在离他们地理位置最近的数据中心。

- 架构特点:

- 数据中心化:全球拥有多个大型数据中心,每个数据中心都是一个独立的、功能齐全的“小Facebook”。

- 数据分片:用户数据被分片,并存储在不同的数据中心,一个用户的所有数据可能都在美国弗吉尼亚的数据中心。

- 异步计算:对于跨数据中心的操作(比如一个欧洲用户给一个美国用户点赞),系统不会等待实时同步完成,而是通过消息队列进行异步处理,以保证核心服务的低延迟。

现代架构的分层解析

我们可以将Facebook的架构分为以下几个逻辑层:

前端层

- 角色:直接与用户浏览器或App交互的层。

- 技术:

- Web前端:使用React(Facebook自己开发的)来构建单页应用,实现动态、高性能的用户界面。

- 移动App:原生应用(iOS/Android)和轻量级的React Native应用。

- 关键组件:

- CDN (Content Delivery Network):Facebook拥有全球最大的私有CDN,称为"CDN in a Box"或"Globally Distributed Cache",它用于缓存静态内容(图片、视频、JS/CSS文件)和部分动态内容,极大减轻了后端服务器的压力,并加速了全球用户的访问速度。

网关层 / 负载均衡层

- 角色:所有进入Facebook数据中心流量的入口。

- 技术:

- 自研负载均衡器:Facebook使用自研的软件负载均衡器,能够处理海量的并发连接,并根据策略将请求分发到后端的Web服务器集群。

- Envoy Proxy:在微服务架构中,Envoy被广泛用作服务网格的边车代理,负责服务发现、负载均衡、路由和健康检查。

应用服务层

- 角色:处理核心业务逻辑的层,由成千上万个微服务组成。

- 技术:

- 编程语言:早期是PHP,现在大量使用C++、Go、Python、Haskell等,C++用于高性能计算,Go用于构建网络服务,Python用于数据科学和脚本。

- 服务框架:基于Thrift或GraphQL构建的内部RPC框架,让服务之间可以高效地调用。

- 部署:使用自研的Buck构建系统和Pyre静态分析工具,以及大规模的容器化技术来部署和管理服务。

数据存储层

这是Facebook架构最核心和最复杂的部分,因为它需要处理PB级甚至EB级的数据,并保证高并发读写。

-

关系型数据库:

- MySQL:仍然是核心,但Facebook对其进行了大量深度定制,

- 存储引擎:开发了MyRocks(基于RocksDB),相比InnoDB更节省空间。

- 分库分表:通过Vitess等工具管理成千上万的MySQL分片。

- 复制:使用基于物理复制的方案,延迟远低于传统的基于日志的复制。

- MySQL:仍然是核心,但Facebook对其进行了大量深度定制,

-

NoSQL数据库:

(图片来源网络,侵删)

(图片来源网络,侵删)- Cassandra:Facebook是Cassandra的创造者和最大用户,它用于处理大规模的、高写入负载的场景,如消息收件箱、时间线数据等,其去中心化和高可用的特性完美契合了Facebook的需求。

- ScyllaDB:一个与Cassandra兼容但性能更高的C++替代品,Facebook也在积极使用。

-

图数据库:

- Graph Search / Social Graph:社交网络本质上是一个巨大的图,Facebook开发了专门的图数据库和查询引擎来高效地处理社交关系查询,朋友的朋友”、“共同兴趣”等。

-

缓存层:

- Memcached:Facebook是Memcached的最大用户,用于缓存数据库查询结果、页面片段等,以减轻数据库压力,其集群规模极其庞大,分布在全球多个数据中心。

-

分布式文件系统:

- HDFS (Hadoop Distributed File System):用于存储海量原始数据,供后续的批处理分析使用。

- Haystack:Facebook专门为存储海量照片而设计的对象存储系统,优化了元数据读取和照片检索效率。

基础设施层

- 硬件:Facebook是全球最大的服务器采购商之一,他们与OEM厂商合作,设计定制化的服务器(“Catapult”项目)、存储设备和网络设备,以最大化性能和降低成本,他们还大规模使用GPU进行AI和机器学习计算。

- 网络:构建了全球最大的软件定义网络之一,使用BGP进行路由,并开发了6Tbps的Torch交换机,以实现数据中心内部的高速数据传输。

- 数据中心:设计并运营了高度自动化、模块化的数据中心,使用风冷等节能技术,以PUE值接近1.1为目标。

关键技术栈总结

| 层次 | 关键技术/组件 | 用途 |

|---|---|---|

| 前端 | React, React Native, GraphQL | 构建用户界面,定义API |

| 网关 | 自研负载均衡器, Envoy Proxy | 流量入口,服务发现,负载均衡 |

| 应用服务 | C++, Go, Python, Thrift, Buck | 业务逻辑处理,微服务通信 |

| 数据存储 | MySQL (MyRocks, Vitess), Cassandra, ScyllaDB, Memcached, Haystack | 结构化数据、社交图、缓存、对象存储 |

| 基础设施 | 自研服务器/交换机, 自建数据中心, GPU | 硬件基础,计算资源 |

| 大数据/AI | Hadoop, Spark, FBLearner (PyTorch) | 数据分析,机器学习,模型训练 |

Facebook的网站架构是一个为全球数十亿用户量身定制的、高度优化的分布式系统,它不再是简单的技术堆砌,而是一套完整的、自上而下的工程哲学和实践的体现,其成功的关键在于:

- 拥抱开源并深度定制:不仅使用开源技术,还对其进行改造和优化,甚至创造新的开源项目。

- 软硬件协同设计:从应用层到底层硬件进行全栈优化,以达到最佳性能和成本效益。

- 数据驱动决策:所有架构变更都基于海量数据分析和A/B测试的结果。

- 持续演进:架构不是一成不变的,而是随着业务增长和技术的进步不断迭代和优化。

理解Facebook的架构,就是理解了现代超大规模互联网服务设计的巅峰之作。